Temi del Blog

SCOPRI I NOSTRI CORSI

-

Psicologo esperto ausiliario della Polizia Giudiziaria (PG) in fase di indagini preliminari

€77,40-€129,00

€129,00-€129,00

ChatGPT: da millenni di pensiero umano al dialogo con le macchine

ChatGPT: da millenni di pensiero umano al dialogo con le macchine

Condividi questo articolo:

Stefania Tucci, psicologa , psicoterapeuta, divulgatrice scientifica, co-founder, membro del CTS e responsabile della divulgazione di Psicologia in Tribunale.

ChatGPT non è solo una curiosa invenzione tecnologica, ma il risultato di un lungo processo storico, scientifico e culturale. La sua nascita affonda le radici in una tradizione millenaria: quella della matematizzazione del pensiero umano, ovvero del tentativo di tradurre idee, linguaggio e logica in formule calcolabili da una macchina.

Questa evoluzione ha avuto un’accelerazione nel mondo contemporaneo, dove la capacità di raccontarsi — nei curriculum, nei social network, nei siti di incontri — è diventata centrale. In un contesto sociale che esalta la realizzazione individuale, l’assistenza dell’intelligenza artificiale rappresenta una risposta concreta alla pressione sempre più forte di produrre contenuti chiari, coerenti, ben scritti.

Il salto tecnologico dei modelli linguistici

La rivoluzione che ha portato alla nascita di ChatGPT si è concretizzata a partire dagli anni 2010, con lo sviluppo dei modelli linguistici di grandi dimensioni (Large Language Models, LLM). Il cuore di questa rivoluzione è un concetto nato negli anni Sessanta: la semantica distribuzionale, secondo cui il significato di una parola può essere dedotto dalle parole che la circondano. Se si conosce abbastanza bene come una parola appare nei testi, si può “prevedere” la parola successiva in una frase. Ed è esattamente questo che fa ChatGPT.

I modelli come GPT (Generative Pre-trained Transformer) imparano leggendo enormi quantità di testo: nel caso di GPT-3, si parla di circa 300 miliardi di parole prese da internet, libri e Wikipedia. Durante l’addestramento, l’algoritmo costruisce un’immensa rete di relazioni tra le parole, imparando a generare frasi che suonano naturali perché sono statisticamente simili a quelle usate da milioni di esseri umani.

Emily Bender e Timnit Gebru hanno definito questi modelli “pappagalli stocastici”: macchine che non capiscono davvero, ma ripetono e rimescolano i dati appresi. Eppure, questa capacità di combinare contenuti già esistenti in modi nuovi è una forma — seppur rudimentale — di creatività, non lontana da quella che gli umani stessi usano ogni giorno.

La potenza dei Transformer

Un’altra svolta decisiva è arrivata con l’introduzione dei transformer, una tipologia di rete neurale sviluppata da Google nel 2017. I transformer permettono al sistema di analizzare tutte le parole di una frase contemporaneamente, e di cogliere il senso globale di un testo grazie a un meccanismo detto “attenzione”, che individua le parti più rilevanti del contesto. Questo consente di comprendere strutture linguistiche complesse e persino la ricorsività, cioè la capacità di incastrare una frase dentro un’altra — una caratteristica chiave del linguaggio umano.

L’équipe di OpenAI ha saputo applicare in modo straordinario questi strumenti, costruendo GPT-3 (e successivamente GPT-4), modelli con centinaia di miliardi di parametri, paragonabili per complessità alle connessioni del cervello umano. L’addestramento ha richiesto supercomputer potentissimi e milioni di dollari in risorse computazionali.

Una scatola nera con l’aiuto umano

Nonostante la potenza dei calcoli, i modelli come ChatGPT non sono infallibili. L’intelligenza artificiale resta, in molti casi, una “scatola nera”: il funzionamento interno è comprensibile in termini matematici, ma l’enorme quantità di operazioni rende difficile spiegare perché un certo risultato viene generato. Per questo motivo, ChatGPT è stato migliorato con l’aiuto umano, attraverso un processo chiamato apprendimento per rinforzo con feedback umano (RLHF). Migliaia di operatori hanno valutato le risposte del modello, correggendole e guidandolo a produrre risposte più pertinenti, sicure e utili.

Dalla decisione alla generazione

Mentre le prime IA aiutavano a prendere decisioni (ad esempio, distinguere un gatto da un cane o riconoscere un semaforo), le IA generative creano contenuti. ChatGPT è capace di produrre testi, rispondere a domande, simulare conversazioni. Per questo viene percepito come un’entità con cui “parlare”: la sua forma conversazionale ci appare naturale, persino familiare.

Ma ciò che rende davvero speciale ChatGPT è la sua capacità di generalizzare: può parlare di scienza, filosofia, cucina o poesia, adattandosi al tono e all’intento di chi gli parla. È un modello che ha imparato la langue, come la definiva il linguista Ferdinand de Saussure: il sistema collettivo e astratto delle regole del linguaggio, non l’uso personale (la parole). Ed è proprio su questa conoscenza astratta e distribuita che costruisce ogni sua risposta.

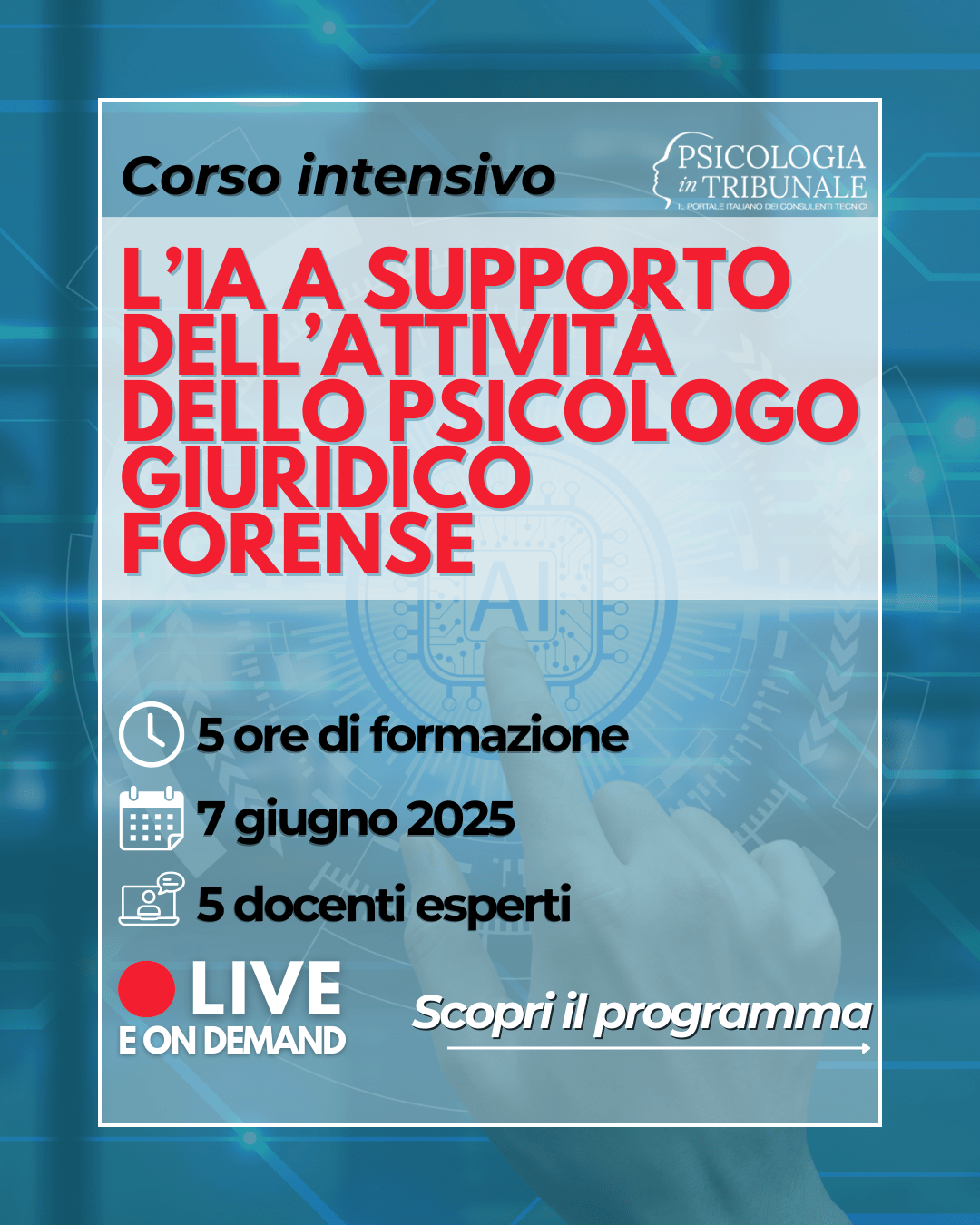

Per indagare meglio i temi posti dall’utilizzo dell’IA, abbiamo ideato un corso intensivo che ti fornirà strumenti pratici e indicazioni operative per integrare l’intelligenza artificiale nella tua professione, consentendoti di affrontare le sfide del futuro con maggiore consapevolezza e competitività.

Il corso si svolgerà Live sabato 7 giugno 2025, e vedrà la partecipazione tra i docenti di personalità del mondo psicologico e giuridico, come il Prof. Giuseppe Sartori e l’avv. Giampaolo Di Marco, e la cofondatrice di PiT, Stefania Tucci, nonché di Sara D’Angelo e Alessia Mensurati, psicologhe ed esperte collaboratrici della Redazione di PiT.

Prenota il tuo posto oggi stesso!

Acquistalo scontato fino al 40% abbonandoti alla Community

di Psicologia in Tribunale!

Paga in 3 rate senza interessi da 30€ a 2.000€

Dal nostro Blog

L’allarme “maranza”, tra stigma sociale e responsabilità collettiva

Mettere uno schermo alla paura

Oltre il clamore mediatico: le competenze genitoriali e le metodologie di valutazione evidence-based

Trattamento IVA

Liquidazione dei compensi ai CTU nel gratuito patrocinio alla luce di Corte Cost. 217/19

La liquidazione giudiziale del compenso al Consulente / Perito psicologo. Una questione irrisolta

Ti è stato utile questo articolo?

ISCRIVITI alla nostra

×

Iscriviti alla nostra Newsletter

Rimani aggiornata con i nuovi corsi e le promozioni.